Au cours du dernier trimestre, une équipe d'analystes du secteur de la vente au détail a lancé une stratégie de prix compétitifs basée sur l'extraction de données provenant des sites web de concurrents. En quelques semaines, elle a réduit les prix de 200 produits. Résultat ? Une perte de revenus de 340 000 dollars avant que quelqu'un ne découvre la vérité : leur outil d'extraction avait collecté des prix promotionnels obsolètes au lieu des listes actuelles. Les informations étaient techniquement exactes au moment de leur collecte, mais complètement erronées pour la prise de décision.

Ce scénario se produit quotidiennement dans les entreprises du monde entier. La technologie de collecte a considérablement progressé en 2026, grâce à l'automatisation basée sur l'IA et aux solutions sans code qui rendent l'extraction accessible à tous. Mais l'accessibilité ne garantit pas la qualité.

Le véritable défi n'est pas de collecter des informations, mais de s'assurer que celles-ci sont exactes, fiables et exploitables. Nous avons vu des entreprises commettre des erreurs qui leur ont coûté des millions de dollars parce qu'elles se sont fiées à des résultats d'extraction non validés. L'assurance qualité n'est pas facultative, c'est le fondement d'une collecte d'informations réussie.

Tout au long de ce guide, nous vous présenterons notre processus de validation en sept étapes qui a fait ses preuves. Vous découvrirez des techniques de contrôle qualité intégrées qui fonctionnent aussi bien pour l'extraction de quelques dizaines de pages que pour des opérations à l'échelle d'une entreprise avec des millions d'enregistrements. Nous aborderons les méthodes de validation assistées par l'IA, les systèmes de surveillance en temps réel et les outils d'évaluation spécialisés qui garantissent que vos projets d'extraction fournissent à chaque fois des résultats fiables.

Points clés

- Des résultats d'extraction non validés peuvent entraîner des décisions commerciales coûteuses et un gaspillage de ressources qui ont un impact sur vos résultats financiers.

- L'assurance qualité doit être intégrée à l'ensemble de votre flux de travail d'extraction, et non considérée comme un simple contrôle final.

- Notre cadre de validation en sept étapes garantit la précision à chaque étape, de la conception de la stratégie à la surveillance automatisée.

- En 2026, les outils de validation basés sur l'IA permettront d'effectuer des contrôles de qualité en temps réel afin de détecter les erreurs avant qu'elles n'affectent les décisions.

- Les techniques d'évaluation spécialisées varient selon le type d'informations. La tarification nécessite une validation différente de celle des coordonnées ou des spécifications des produits.

- Les projets à l'échelle de l'entreprise comportant des millions d'enregistrements nécessitent des systèmes de contrôle qualité automatisés, et non des vérifications manuelles.

Pourquoi la vérification des données est-elle essentielle à la réussite du web scraping ?

De nombreuses entreprises dépensent des milliers d'euros dans le web scraping pour finalement se rendre compte que leurs données sont inutilisables. Le véritable défi réside dans la vérification des données. Sans vérification, même les outils de scraping les plus avancés produisent des résultats peu fiables, ce qui nuit à votre entreprise.

Aujourd'hui, les entreprises s'appuient sur des données précises pour prendre des décisions, analyser le marché et innover. Une mauvaise qualité des données web perturbe tous les processus. Votre analyse concurrentielle, votre automatisation et vos études de marché en pâtissent, ce qui vous induit en erreur.

Comprendre l'importance de la vérification permet d'éviter des erreurs coûteuses. Examinons les effets des données scrapées non vérifiées et pourquoi la validation est essentielle en 2026.

Le coût réel des données scrapées non vérifiées

La mauvaise qualité des données web coûte plus cher que l'investissement initial dans le scraping. Les entreprises ont perdu plus de 50 000 dollars en dépenses de marketing pour des adresses email invalides. Ces pertes ne sont que la partie émergée de l'iceberg.

Prenons l'exemple d'une équipe chargée de la tarification qui prend des décisions sur la base de données non vérifiées sur la concurrence. Les erreurs contenues dans ces données peuvent faire sortir votre entreprise du marché ou vous priver de revenus. Un client du secteur du commerce électronique a corrigé sa stratégie de tarification et récupéré près de 200 000 dollars de marge perdue en seulement trois mois.

Les équipes doivent ré-extraire les données en raison de problèmes de qualité, ce qui entraîne une perte de temps et de ressources. Les développeurs passent des jours à corriger des problèmes qui auraient pu être détectés immédiatement par la vérification. Les analystes perdent du temps à nettoyer les ensembles de données au lieu de fournir des informations.

Les initiatives d'automatisation qui échouent entraînent également des coûts cachés. De mauvaises données conduisent à de mauvais résultats. Les systèmes CRM contenant des informations de contact incorrectes ne parviennent pas à communiquer. Les systèmes de gestion des stocks contenant des données produit erronées entraînent des ruptures de stock ou des surstockages.

Problèmes courants liés à la qualité des données qui compromettent vos projets

Nous constatons souvent les mêmes problèmes dans les projets de web scraping. Les enregistrements incomplets constituent un problème majeur, avec des champs essentiels manquants tels que les adresses email ou les informations sur les prix. Ces lacunes rendent les ensembles de données inutilisables.

Les incohérences de formatage perturbent les systèmes en aval qui attendent des entrées standardisées. Les numéros de téléphone, les adresses et les dates se présentent sous différents formats, ce qui nécessite un traitement supplémentaire. Chaque variation complique le processus de vérification.

Les entrées en double gonflent la taille des ensembles de données et faussent les résultats des analyses. La présence d'un même enregistrement à plusieurs reprises rend les mesures peu fiables. Le nombre de visiteurs, les estimations de la taille du marché et les analyses de tendances sont tous affectés.

Voici les problèmes les plus fréquents que nous identifions en matière d'exactitude des données dans le web scraping :

- Erreurs structurelles : données extraites d'éléments de page erronés ou de champs mal alignés

- Informations obsolètes : contenu qui ne reflète plus la réalité actuelle

- Problèmes d'encodage : caractères spéciaux qui s'affichent de manière incorrecte

- Incompatibilités de types : nombres stockés sous forme de texte ou dates dans des formats incorrects

- Prolifération des valeurs nulles : champs vides qui devraient contenir des données

Chaque problème se répercute sur l'ensemble de votre pipeline de données, amplifiant les erreurs à chaque étape. Une seule incohérence de formatage lors de la phase de scraping se transforme en défaillance à l'échelle du système lorsque ces données sont intégrées à votre plateforme d'automatisation. Plus vous détectez ces problèmes tôt, moins ils causent de dommages.

Quels sont les enjeux en 2026 ?

L'importance de la vérification des données s'est considérablement accrue ces dernières années. La réglementation en matière d'exactitude des données s'est renforcée dans plusieurs juridictions. Les entreprises s'exposent à des sanctions si elles prennent des décisions sur la base d'informations non vérifiées, avec des conséquences graves dans les secteurs réglementés tels que la finance et la santé.

Les systèmes modernes de veille économique amplifient l'impact des données erronées. Lorsque vos plateformes d'analyse traitent des millions d'enregistrements, même de faibles taux d'erreur produisent des distorsions massives. Un problème de qualité des données de 2 % dans vos données sources se traduit par un problème d'exactitude de 20 % dans vos rapports finaux.

Le désavantage concurrentiel représente l'enjeu le plus important. Vos concurrents qui mettent en œuvre des mesures rigoureuses de vérification des données récupérées obtiennent des informations sur le marché qui vous échappent. Ils identifient plus rapidement les opportunités, réagissent plus vite aux menaces et prennent de meilleures décisions stratégiques.

Les systèmes d'intelligence artificielle et d'apprentissage automatique augmentent encore les enjeux. Ces technologies consomment d'énormes quantités de données pour entraîner leurs modèles. Si vous leur fournissez des données scrapées non vérifiées, elles apprennent des modèles incorrects. Votre moteur de tarification alimenté par l'IA fait de mauvaises recommandations. Vos analyses prédictives génèrent de fausses prévisions.

Le principe « garbage in, garbage out » (si l'on entre des données erronées, on obtient des résultats erronés) n'a jamais été aussi pertinent. En 2026, avec l'automatisation qui régit de plus en plus les processus métier, vous ne pouvez pas vous permettre de vous appuyer sur des bases peu fiables. Chaque décision, chaque automatisation, chaque information dépend de l'exactitude des données issues du scraping web.

Les normes de qualité des données web sont passées du statut de fonctionnalités « agréables à avoir » à celui d'exigences critiques pour l'entreprise. Les entreprises qui sautent les étapes de vérification découvrent leurs erreurs lorsqu'il est trop tard, après que des données erronées ont déjà nui aux relations avec les clients, faussé la planification stratégique ou entraîné des violations de la conformité.

Nous avons aidé des organisations à mettre en place des cadres de vérification appropriés après qu'elles aient subi ces coûteuses défaillances. Le schéma est toujours le même : l'investissement dans la vérification ne représente qu'une fraction du coût de la réparation des dommages causés par des données non vérifiées. Les équipes intelligentes intègrent la vérification dans leur flux de travail dès le premier jour, la considérant comme un élément essentiel et non comme un supplément facultatif.

Comprendre le paysage de la qualité des données Web

La qualité des données Web varie considérablement. Le web scraping imite la navigation humaine, mais il est plus rapide et plus précis. Il consiste à envoyer des requêtes à des URL, à analyser les réponses HTML et à extraire des données spécifiques.

Plusieurs facteurs peuvent affecter la fiabilité des données. Il est essentiel de comprendre ces défis pour mettre en place des stratégies de vérification efficaces.

Pourquoi les données scrapées ne sont-elles pas fiables ?

Plusieurs facteurs menacent la qualité des données Web. Les changements de structure des sites Web constituent un problème majeur. Lorsque la mise en page HTML d'un site change, les scrapers traditionnels échouent souvent.

Le contenu dynamique chargé via JavaScript constitue un autre défi. Les requêtes HTTP standard peuvent passer à côté des données chargées après l'exécution des scripts. Cela peut entraîner la perte d'informations essentielles.

Les protections anti-bot peuvent également fausser les données. Ces systèmes détectent les accès automatisés et peuvent bloquer les requêtes ou fournir des données corrompues. Leur objectif est de contrecarrer les efforts de scraping.

Parmi les autres problèmes de fiabilité, on peut citer

- Formatage des données incohérent entre les différentes pages ou sections d'un même site web

- Variations temporelles lorsque le contenu change entre les sessions de scraping

- Problèmes d'encodage qui déforment les caractères spéciaux et le texte international

- Chargement incomplet des pages entraînant une extraction partielle des données

Les approches adaptatives utilisant l'IA permettent de mieux gérer les variations structurelles. Ces systèmes apprennent des modèles, améliorant ainsi la précision des données lors du scraping web.

Principaux indicateurs de vérification que nous suivons

Pour valider efficacement les données extraites, nous nous concentrons sur cinq dimensions clés de la qualité. Chaque indicateur fournit des informations sur différents aspects de la fiabilité de votre ensemble de données.

L'exhaustivité mesure le pourcentage de champs obligatoires contenant des valeurs réelles. Par exemple, si vous extrayez des listes de produits comportant dix attributs, l'exhaustivité indique combien d'enregistrements contiennent les dix champs.

La précision confirme l'exactitude des valeurs extraites. Nous vérifions par sondage des échantillons aléatoires par rapport aux pages web d'origine. Il est courant de viser une précision de 95 % ou plus pour les projets critiques.

La cohérence garantit un formatage et une structure uniformes dans l'ensemble de votre jeu de données. Les numéros de téléphone doivent avoir le même format, les dates doivent suivre des modèles cohérents et les valeurs catégorielles doivent correspondre à des normes prédéfinies.

Nous suivons également ces indicateurs essentiels :

- Actualité : fraîcheur et pertinence des informations extraites

- Validité : conformité aux types et formats de données attendus

- Unique : absence de doublons dans votre ensemble de données

- Intégrité : relations appropriées entre les points de données connectés

La définition de seuils acceptables dépend des besoins de votre projet. Les données financières exigent une précision quasi parfaite, tandis que les applications moins sensibles peuvent tolérer des taux d'erreur plus élevés. Il est judicieux de documenter ces normes avant de procéder au scraping.

La différence entre validation et vérification

La validation et la vérification sont souvent confondues, mais elles représentent des processus de contrôle qualité distincts. Il est essentiel de comprendre cette distinction pour mettre en place des systèmes de vérification robustes.

La validation confirme que les données sont conformes aux schémas et formats attendus. Il s'agit ici de l'exactitude structurelle. Lorsque vous validez des données extraites, vous vérifiez si un champ email contient une adresse email correctement formatée, si un champ prix contient une valeur numérique et si les champs obligatoires ne sont pas vides.

La validation a lieu pendant ou immédiatement après l'extraction. Elle permet de détecter les erreurs techniques telles que les échecs d'analyse, les incompatibilités de types et les problèmes structurels. Ces vérifications s'effectuent automatiquement et fournissent un retour d'information instantané.

La vérification confirme que les données sont exactes et reflètent la réalité. Il s'agit ici de l'exactitude sémantique. Une adresse e-mail peut être parfaitement formatée, mais fausse. Un numéro de téléphone peut passer les contrôles de format, mais être hors service.

La vérification nécessite souvent des contrôles externes auprès de sources faisant autorité. Pour les adresses email, cela signifie se connecter à des serveurs de messagerie. Pour les numéros de téléphone, cela implique de rechercher les opérateurs. Pour les adresses, cela nécessite les bases de données des services postaux.

Ces deux processus sont essentiels et complémentaires. La validation détecte les erreurs techniques lors de l'extraction. La vérification garantit que les données extraites sont correctes et utilisables pour l'usage auquel elles sont destinées. Nous mettons en œuvre la validation comme première ligne de défense et la vérification comme dernier contrôle qualité avant que les données n'entrent dans les systèmes de production.

Étape 1 : Concevez votre stratégie de vérification des données avant le scraping

Une stratégie de vérification bien conçue transforme les données brutes extraites en un atout commercial fiable. Se lancer dans l'extraction sans plan clair pour le contrôle qualité conduit souvent à l'échec du projet. Le processus de vérification des données extraites le plus efficace commence avant même que vous n'écriviez la première ligne de code.

Planifier à l'avance permet d'économiser du temps, de l'argent et de la frustration. Établir des normes de vérification dès le départ permet d'éviter les problèmes de qualité des données qui nécessiteraient des corrections coûteuses par la suite. Cette approche stratégique garantit que chaque étape de vérification du scraping des données est alignée sur vos objectifs commerciaux.

Établissez des normes de qualité claires pour votre projet

La première question que nous posons est simple : que signifie « bonnes données » pour votre projet spécifique ? Sans exigences de qualité claires, il est impossible de vérifier les données récupérées ou de mesurer le succès. Nous devons définir des normes concrètes et mesurables que tous les membres de l'équipe comprennent.

Commencez par identifier les champs de données qui sont absolument essentiels par rapport à ceux qui sont simplement utiles. Les données financières exigent généralement une précision de 99 %, tandis que les champs de texte descriptifs peuvent être acceptables à 95 %. Cette distinction est importante, car elle détermine où nous concentrons nos efforts de vérification.

Ensuite, nous établissons des plages de valeurs et des formats acceptables pour chaque champ. Les adresses e-mail doivent correspondre à des modèles standard. Les numéros de téléphone doivent comporter un nombre spécifique de chiffres. Les dates doivent être formatées de manière cohérente. Ces normes deviennent les références que nous utilisons tout au long du processus de vérification des données récupérées.

Les exigences en matière d'actualité des données méritent une attention particulière. Certains projets nécessitent des données en temps réel, tandis que d'autres peuvent fonctionner avec des mises à jour hebdomadaires. Nous documentons clairement ces délais, car ils ont une incidence à la fois sur la fréquence de collecte et sur les méthodes de vérification.

Créez des points de contrôle de vérification tout au long de votre pipeline

Nous ne considérons pas la vérification comme une tâche unique à la fin du processus. Au contraire, nous mettons en place plusieurs points de contrôle tout au long du flux de travail. Cette approche par étapes permet de détecter les erreurs à un stade précoce, lorsqu'elles sont plus faciles et moins coûteuses à corriger.

Notre processus de vérification comprend quatre étapes essentielles. Les vérifications préalables au scraping permettent de s'assurer que les URL cibles sont accessibles et renvoient les codes d'état attendus. Cela évite de gaspiller des ressources sur des sources inaccessibles ou bloquées.

La validation pendant le scraping s'effectue en temps réel, au fur et à mesure que les données transitent par votre scraper. Nous mettons en œuvre des vérifications de schéma afin de nous assurer que les données entrantes correspondent aux structures attendues. La validation du format permet de détecter immédiatement les problèmes tels que les adresses email mal formées ou les numéros de téléphone invalides.

Le troisième point de contrôle intervient après l'extraction. C'est là que nous appliquons une vérification spécialisée pour des types de données spécifiques. Les services de vérification des email vérifient la délivrabilité. La validation des numéros de téléphone confirme les formats des numéros et les informations sur les opérateurs. La vérification des adresses normalise les données de localisation.

Enfin, nous effectuons un examen complet de l'ensemble de données avant de considérer le projet comme terminé. Cela comprend une validation croisée par rapport à plusieurs sources, la détection des anomalies statistiques et des contrôles de cohérence logique. Lorsque vous comprenez comment vérifier les données web extraites à chaque étape, vous renforcez votre confiance dans votre ensemble de données final.

Choisissez les méthodes et les outils de vérification appropriés

Les outils que vous sélectionnez déterminent l'efficacité avec laquelle vous pouvez vérifier les données extraites tout au long de votre projet. Nous équilibrons l'automatisation et la supervision humaine, en choisissant des solutions qui correspondent à nos besoins spécifiques et à nos contraintes budgétaires.

Les fonctionnalités de validation intégrées au scraper constituent la première ligne de défense. Les frameworks de scraping modernes incluent des vérifications de base des codes de réponse, des délais d'expiration et de la validation de la structure des données. Ces fonctionnalités détectent les problèmes évidents sans infrastructure supplémentaire.

Pour les types de données spécialisés, nous nous appuyons sur des API de vérification tierces. Les services de vérification de l'email vérifient la syntaxe, la validité du domaine et l'existence de la boîte mail. Les outils de validation des numéros de téléphone vérifient les formats des numéros, identifient les opérateurs et signalent les lignes déconnectées. Les API de vérification des adresses normalisent le formatage et confirment la délivrabilité.

Des scripts de validation personnalisés comblent les lacunes des solutions standard. Nous écrivons des scripts Python pour les règles de validation spécifiques à l'industrie, les vérifications de la logique métier et les exigences en matière de format de données propriétaires. Ces scripts s'intègrent de manière transparente dans nos étapes de vérification du scraping de données.

Les contrôles manuels ponctuels restent précieux malgré les progrès de l'automatisation. Nous établissons des protocoles permettant aux vérificateurs humains d'échantillonner des enregistrements aléatoires, de vérifier les cas limites et d'identifier les modèles que les systèmes automatisés pourraient manquer. Cette combinaison de vérification automatisée et manuelle permet un contrôle qualité robuste.

L'investissement dans des services de vérification haut de gamme dépend de votre volume de données et de vos exigences en matière de précision. Les projets à enjeux élevés comportant des millions d'enregistrements justifient des services d'abonnement. Les projets plus modestes peuvent réussir avec des outils open source et une vérification manuelle. Nous vous aidons à trouver le juste équilibre pour votre situation.

La documentation permet de tout relier. Nous créons des procédures claires pour chaque méthode de vérification, établissons des procédures d'escalade en cas d'erreurs et définissons des seuils de qualité qui déclenchent des alertes. Cette approche systématique garantit des résultats cohérents, quelle que soit la personne qui utilise le scraper.

Étape 2 : Configurez votre infrastructure de scraping pour garantir l'exactitude des données

Avant d'extraire des données, vous devez mettre en place une infrastructure solide pour garantir leur précision. Les fondations que vous créez déterminent la qualité de vos données. Nous avons constaté que les choix initiaux en matière d'infrastructure ont un impact considérable sur la qualité des données tout au long du processus de scraping.

De nombreuses équipes commencent à scraper sans tenir compte de l'impact de leurs choix d'outils sur l'exactitude des données. Cette approche entraîne des erreurs et compromet la qualité des données. Une infrastructure bien configurée minimise ces risques et garantit une collecte de données fiable.

Choisissez les bons outils : Python, Selenium et Playwright

La plupart des guides de scraping recommandent des outils d'automatisation des navigateurs, mais ceux-ci ne sont pas toujours nécessaires. Nous utilisons Python avec la bibliothèque requests pour environ 80 % de nos projets. Elle gère efficacement le HTML statique avec un minimum de frais généraux. Un appel requests prend environ 200 millisecondes, tandis que les méthodes basées sur un navigateur prennent plusieurs secondes.

La bibliothèque requests, associée à BeautifulSoup, offre la solution la plus rapide et la plus rentable pour le contenu statique. Cette combinaison permet une extraction plus rapide des données, une utilisation réduite des ressources du serveur et une maintenance plus simple du code.

Pour le contenu dynamique, vous avez besoin d'outils d'automatisation des navigateurs. Selenium et Playwright sont essentiels pour traiter les requêtes AJAX, le défilement infini et le contenu qui apparaît après l'interaction de l'utilisateur.

Selenium est la norme depuis des années, offrant une prise en charge étendue des navigateurs et un écosystème mature. Nous l'utilisons pour les interactions complexes nécessitant un contrôle précis du navigateur. Mais Playwright est devenu notre choix préféré en 2026 pour traiter le contenu rendu en JavaScript.

Playwright offre plusieurs avantages qui ont un impact direct sur la précision des données :

- Des vitesses d'exécution plus rapides qui réduisent les erreurs de délai d'attente et la collecte de données incomplètes

- Des sélecteurs d'éléments plus fiables qui réduisent les tentatives d'extraction infructueuses

- Des mécanismes d'attente intégrés qui garantissent le chargement complet du contenu avant l'extraction

- Une meilleure gestion des frameworks web modernes tels que React et Next.js

- Prise en charge native de plusieurs contextes de navigateur sans surcharge de ressources

La logique de décision est simple. Commencez par les requêtes HTML statiques. Utilisez Playwright lorsque le rendu JavaScript est nécessaire. Réservez Selenium aux projets hérités ou aux comportements spécifiques des navigateurs qui ne sont pas pris en charge par Playwright.

Configurez des proxys pour une collecte de données propre

Les proxys sont essentiels pour obtenir des données précises et impartiales. Sans une configuration proxy appropriée, les sites web peuvent servir un contenu différent, bloquer des requêtes ou fournir des données biaisées.

Nous configurons des proxys pour garantir que les données reflètent l'expérience réelle des utilisateurs. Il ne s'agit pas de se cacher, mais d'assurer l'exactitude des données. Le ciblage géographique nécessite des proxys provenant d'emplacements spécifiques afin de vérifier l'exactitude des données régionales.

Proxys HTTP vs SOCKS5 vs SOCKS4

Il est essentiel de comprendre les protocoles proxy pour choisir la solution la plus précise. Chaque protocole fonctionne différemment et répond à des cas d'utilisation spécifiques qui affectent la qualité de la collecte de données.

Les serveurs proxy HTTP fonctionnent au niveau de la couche application et ne gèrent que le trafic HTTP et HTTPS. Ils constituent l'option la plus rapide pour le web scraping, avec la latence la plus faible et le débit le plus élevé. Nous utilisons des proxys HTTP pour les tâches de scraping standard où la vitesse est importante et où les systèmes de détection ne sont pas sophistiqués.

Le proxy SOCKS4 est un protocole plus ancien et plus simple qui ne prend pas en charge l'authentification. Il offre des fonctionnalités de base pour les connexions TCP, mais ne dispose pas des fonctionnalités de sécurité de SOCKS5. Nous utilisons rarement les options de proxy SOCKS4 en 2026, sauf lorsque nous travaillons avec des systèmes hérités qui ne prennent pas en charge les protocoles plus récents.

Les serveurs proxy SOCKS5 fonctionnent à un niveau réseau inférieur, offrant une plus grande flexibilité et un meilleur anonymat. Ils prennent en charge l'authentification, gèrent le trafic UDP et fonctionnent avec n'importe quel protocole. Les proxys SOCKS5 offrent une meilleure sécurité et sont plus difficiles à détecter par les sites web en tant que trafic proxy. Nous déployons des configurations de proxy socks5 lorsque nous scrapons des sites dotés de systèmes anti-bot avancés ou lorsque nous maintenons des sessions cohérentes sur plusieurs requêtes.

Voici une comparaison pratique pour vous aider dans votre choix :

- Priorité à la vitesse : les proxys HTTP offrent les performances les plus rapides pour un scraping simple

- Besoins en matière de sécurité : les proxys SOCKS5 offrent un meilleur anonymat et de meilleures options d'authentification

- Flexibilité du protocole : SOCKS5 gère le trafic non HTTP lorsque le scraping nécessite des protocoles supplémentaires

- Compatibilité avec les anciens systèmes : SOCKS4 fonctionne avec les anciens systèmes, mais offre des fonctionnalités limitées

Meilleures pratiques de configuration des proxys Elite

Les serveurs proxy Elite offrent le plus haut niveau d'anonymat en ne s'identifiant pas comme des proxys dans les en-têtes de requête. Les sites web ne peuvent pas détecter que vous utilisez un proxy, ce qui est essentiel pour collecter des données précises à partir de sites soumis à des contrôles d'accès stricts.

Nous mettons en œuvre plusieurs bonnes pratiques lors de la configuration de proxys élite pour garantir l'exactitude des données :

- Stratégies de rotation : faites tourner les adresses IP selon un calendrier qui imite les habitudes de navigation naturelles, ni trop rapide pour déclencher une limitation du débit, ni trop lent pour gaspiller les ressources du proxy

- Tests de qualité : nous testons chaque proxy avant son déploiement en vérifiant les temps de réponse, les taux de réussite et si le proxy anonymise correctement les requêtes.

- Correspondance géographique : utilisez des proxys provenant de la même région géographique que votre public cible afin de vous assurer que vous collectez des données précises au niveau régional.

- Gestion de l'authentification : mettez en place une authentification sécurisée qui n'expose pas les identifiants dans votre code ou vos journaux.

- Surveillance des performances : suivez les indicateurs de santé des proxys pendant les opérations de scraping afin d'identifier et de remplacer automatiquement les proxys peu performants.

Nous disposons également d'un pool de proxys de secours. Lorsqu'un proxy tombe en panne ou est bloqué, notre système bascule automatiquement vers une alternative sans interrompre la collecte de données. Cette redondance garantit un fonctionnement continu et évite les lacunes dans les données qui pourraient compromettre la précision.

Configurer des navigateurs sans interface graphique et des navigateurs anti-détection

Lorsque le scraping nécessite l'exécution de JavaScript, les configurations de navigateurs sans interface vous permettent de rendre du contenu dynamique tout en minimisant la consommation de ressources. Les navigateurs sans interface fonctionnent sans interface visible, ce qui réduit l'utilisation de la mémoire et vous permet d'utiliser plusieurs instances de navigateur simultanément pour un scraping parallèle.

Nous configurons Chrome et Firefox sans interface avec des indicateurs spécifiques qui optimisent les performances sans sacrifier la précision des données. La désactivation des fonctionnalités inutiles telles que les images et le CSS lorsque vous n'avez besoin que de données textuelles peut accélérer le scraping de 40 à 60 %. Mais soyez prudent, certains sites détectent les navigateurs sans interface et proposent un contenu différent ou bloquent complètement l'accès.

C'est là que la technologie des navigateurs anti-détection prend toute sa valeur. Les navigateurs anti-détection randomisent les empreintes digitales du navigateur afin que chaque session apparaisse comme un utilisateur unique et légitime. Ils modifient des dizaines de caractéristiques du navigateur, notamment :

- Les paramètres d'empreinte digitale Canvas que les sites web utilisent pour le suivi

- Les signatures de rendu WebGL qui identifient les instances de navigateur

- Les modèles d'énumération des polices qui révèlent les caractéristiques du système

- Les combinaisons de résolution d'écran et de profondeur de couleur

- Les paramètres de fuseau horaire et de langue qui doivent correspondre aux emplacements des proxys

Nous mettons en œuvre des navigateurs anti-détection lorsque nous explorons des sites sophistiqués qui utilisent des systèmes de détection avancés. Cette complexité supplémentaire est justifiée lorsque vous collectez des données de grande valeur à partir de sources qui bloquent activement les explorateurs. En apparaissant comme des utilisateurs légitimes, vous vous assurez que les données que vous collectez reflètent fidèlement l'expérience des utilisateurs réels.

La configuration est très importante pour la précision des données. Nous alignons les paramètres du navigateur anti-détection sur les emplacements de nos proxys. Si vous utilisez un proxy à New York, l'empreinte digitale de votre navigateur doit refléter la configuration système d'un utilisateur new-yorkais type. Les divergences entre l'emplacement du proxy et les caractéristiques du navigateur peuvent déclencher les systèmes de détection et entraîner le blocage des requêtes ou la manipulation des données.

L'infrastructure que vous mettez en place à cette étape constitue la base technique de tout ce qui suit. Avec les bons outils, des proxys correctement configurés et une automatisation du navigateur appropriée, vous êtes en mesure de collecter des données précises de manière cohérente dans tous vos projets de scraping.

Étape 3 : mettre en œuvre une validation en temps réel pendant le processus de scraping

La vérification la plus efficace a lieu pendant que votre scraper collecte activement des données. Attendre la fin de l'extraction signifie découvrir les problèmes trop tard, gaspiller les ressources du serveur et perdre du temps sur des ensembles de données corrompus. La validation en temps réel nous permet de détecter immédiatement les erreurs, d'ajuster la logique d'extraction à la volée et de garantir que chaque enregistrement répond aux normes de qualité avant d'entrer dans notre base de données.

Lorsque nous validons les données scrapées pendant l'extraction, nous transformons l'ensemble de l'opération de scraping. Les validations échouées déclenchent des réponses immédiates, ce qui nous permet de mettre les tâches en pause, d'examiner les problèmes de sélection et d'éviter l'accumulation de milliers d'enregistrements erronés. D'après notre expérience, cette approche proactive réduit le temps de post-traitement jusqu'à 70 %.

En 2026, les infrastructures de scraping modernes prendront en charge des cadres de validation sophistiqués qui s'intègrent directement dans les workflows d'extraction. Ces systèmes vérifient la structure, le format, l'exhaustivité et la logique des données à mesure que chaque enregistrement est capturé, créant ainsi un filet de sécurité qui détecte les problèmes de qualité avant qu'ils ne se multiplient.

Techniques de validation des schémas

La validation des schémas établit le plan structurel que chaque enregistrement scrapé doit respecter. Nous définissons des schémas qui spécifient les champs obligatoires, les champs facultatifs, les types de données, les structures d'objets imbriqués et les contraintes de tableaux. Ce cadre fait office de contrat entre notre scraper et notre pipeline de données.

Le schéma JSON fournit une norme puissante pour définir les règles de validation. Nous créons des documents de schéma qui décrivent en détail les structures de données attendues, y compris les noms de champs, les types, les modèles et les contraintes. Lorsqu'un enregistrement récupéré ne correspond pas au schéma, la validation échoue immédiatement et des messages d'erreur spécifiques identifient la non-conformité.

Les modèles Pydantic en Python offrent des capacités encore plus sophistiquées de vérification des données issues du web scraping. Nous définissons les modèles de données comme des classes Python avec des annotations de type, et Pydantic valide automatiquement les données entrantes par rapport à ces spécifications. La bibliothèque gère la coercition de type, les validateurs personnalisés et les structures imbriquées complexes avec un minimum de code.

- Champs obligatoires : nom du produit, prix, statut de disponibilité

- Champs facultatifs : description, notes, nombre_d'avis

- Contraintes de type : prix sous forme de nombre à virgule flottante, notes comprises entre 0 et 5, nombre_d'avis sous forme d'entier

- Validation du format : les URL doivent inclure le protocole, les dates au format ISO

En 2026, les scrapers alimentés par l'IA fonctionnent de manière transparente avec la validation des schémas. Les outils d'IA modernes tels que Grok comprennent les exigences sémantiques et peuvent structurer les données extraites afin qu'elles correspondent automatiquement aux schémas prédéfinis. L'IA interprète le contenu des pages de manière contextuelle, ce qui rend l'extraction plus résistante aux changements apportés aux sites web.

Nous configurons la validation pour qu'elle s'exécute de manière synchrone pendant l'extraction. Chaque élément extrait passe par le validateur de schéma avant d'être mis en file d'attente pour être stocké. Les éléments non valides sont signalés, enregistrés avec des informations détaillées sur l'erreur et peuvent éventuellement déclencher une logique de réessai avec des stratégies d'extraction alternatives.

Vérification du format et du type de données

Au-delà de la validation structurelle, nous devons vérifier que les valeurs des champs individuels sont conformes aux formats attendus. Différents types de données nécessitent des approches de validation spécifiques pour garantir l'exactitude des données dans les opérations de scraping web. La vérification du format permet de détecter des erreurs subtiles que la validation du schéma pourrait manquer.

Les adresses email doivent être validées par rapport aux normes RFC 5322. Nous utilisons des modèles d'expressions régulières qui vérifient la structure appropriée : partie locale, symbole @, nom de domaine et TLD valide. La validation du format ne suffit pas à confirmer la délivrabilité, c'est pourquoi nous combinons la vérification du format avec les services de vérification des email décrits dans les sections suivantes.

La validation des numéros de téléphone présente des défis particuliers en raison des variations de format à l'échelle internationale. Nous mettons en œuvre des validateurs qui :

- Vérifient le nombre approprié de chiffres en fonction des codes pays

- Valident les indicatifs régionaux par rapport aux plages valides connues

- Suppriment les caractères de formatage pour un stockage cohérent

- Signalent les numéros qui ne correspondent pas aux modèles attendus pour un examen manuel

La validation des URL garantit que les liens récupérés sont correctement formatés et fonctionnels. Nous vérifions la présence du protocole (http/https), contrôlons la syntaxe du domaine, validons les structures des chemins d'accès et effectuons éventuellement des requêtes HEAD pour confirmer que les URL sont accessibles. Cela permet d'éviter que des liens rompus ne polluent nos ensembles de données.

La validation de la date et de l'horodatage nécessite l'analyse des chaînes de caractères dans des formats standardisés. Nous traitons divers formats d'entrée (MM/JJ/AAAA, ISO 8601, horodatages Unix) et les convertissons en représentations cohérentes. Les vérifications de plage garantissent que les dates se situent dans des limites raisonnables, en détectant les erreurs évidentes telles que les dates de publication futures sur du contenu historique.

Les valeurs numériques doivent faire l'objet d'une vérification de type et d'une validation de plage. Les prix doivent être des nombres flottants positifs compris dans des plages raisonnables pour le marché. Les quantités doivent être des nombres entiers positifs. Les notes se situent généralement entre des valeurs minimales et maximales définies. Nous créons des fonctions de validation réutilisables pour chaque type numérique qui vérifient à la fois le format et les contraintes logiques.

Contrôles d'exhaustivité et de valeurs nulles

Les données manquantes représentent l'un des problèmes de qualité les plus courants dans le web scraping. Nous avons besoin d'approches systématiques pour identifier les enregistrements incomplets et faire la distinction entre les champs vides légitimes et les échecs d'extraction. Les contrôles d'exhaustivité protègent contre les scrapers silencieux qui semblent fonctionner correctement mais ne capturent aucune donnée utile.

Nous établissons des seuils acceptables pour les données manquantes en fonction de l'importance des champs. Les champs critiques tels que les noms ou les prix des produits doivent avoir des taux de nullité proches de zéro. Les champs secondaires tels que les descriptions détaillées peuvent tolérer 20 à 30 % de valeurs manquantes. Lorsque les taux de nullité dépassent les seuils, notre système signale les dysfonctionnements possibles des scrapers.

Le suivi de l'exhaustivité au niveau des champs révèle des schémas dans les échecs d'extraction. Si un champ spécifique revient systématiquement vide dans plusieurs enregistrements, le sélecteur est probablement défectueux en raison de modifications apportées au site web. Nous surveillons ces indicateurs en temps réel afin de valider la qualité des données extraites au fur et à mesure de l'extraction.

Pour distinguer les champs vides intentionnels des erreurs d'extraction, il faut tenir compte du contexte. Un produit peut légitimement ne pas avoir d'avis (review_count = 0), mais un nom de produit manquant indique toujours une erreur. Nous encodons ces connaissances du domaine dans nos règles de validation, en traitant les différentes valeurs nulles de manière appropriée en fonction de la sémantique des champs.

Des stratégies d'extraction de secours sont activées lorsque les sélecteurs principaux échouent. Nous définissons des chemins d'extraction secondaires et tertiaires pour les champs critiques. Si le sélecteur CSS principal renvoie une valeur nulle, le système essaie automatiquement d'autres sélecteurs, expressions XPath ou modèles regex. Cette résilience améliore considérablement les taux d'exhaustivité.

Les scores d'exhaustivité au niveau des enregistrements nous aident à hiérarchiser la qualité des données. Nous calculons le pourcentage de champs obligatoires non nuls pour chaque enregistrement. Les éléments inférieurs aux seuils d'exhaustivité sont signalés pour une validation renforcée, une révision manuelle ou un nouveau scraping. Ce système de notation nous permet de prendre des décisions éclairées quant aux enregistrements à conserver ou à supprimer.

Systèmes de signalement immédiat des erreurs

Les alertes en temps réel transforment la vérification des données web scrapées, qui était auparavant une analyse a posteriori, en un processus de surveillance active. Lorsque des échecs de validation se produisent pendant l'extraction, nous avons besoin d'une notification immédiate pour éviter de gaspiller des ressources sur des scrapings ayant échoué. Les systèmes de signalement des erreurs fournissent cette boucle de rétroaction essentielle.

Nous mettons en œuvre des systèmes d'alerte à plusieurs niveaux en fonction de la gravité et de la fréquence des erreurs. Les échecs de validation uniques peuvent générer des avertissements sans interrompre le scraping. Les taux d'échec soutenus supérieurs aux seuils définis déclenchent des notifications immédiates par e-mail, Slack ou SMS. Les erreurs critiques telles que les échecs d'authentification ou les blocages d'IP interrompent immédiatement les tâches de scraping.

Les stratégies de journalisation capturent à la fois les succès et les échecs avec suffisamment de détails pour le débogage. Chaque contrôle de validation génère des entrées de journal structurées, notamment :

- Horodatage : moment où la validation a eu lieu

- Identifiant de l'enregistrement : URL ou identifiant unique de l'élément récupéré

- Type de validation : schéma, format, exhaustivité ou vérification logique

- Statut de réussite/échec : indication claire du résultat de la validation

- Détails de l'erreur : description spécifique de ce qui a échoué et pourquoi

La visualisation du tableau de bord nous permet de voir d'un seul coup d'œil l'état de vérification des données extraites du web. Nous surveillons en temps réel les taux de réussite, la répartition des erreurs, l'exhaustivité au niveau des champs et la vitesse d'extraction. Des algorithmes de détection des anomalies identifient les changements soudains dans les mesures de validation qui pourraient indiquer une défaillance du scraper.

Des mécanismes de pause automatique protègent contre les défaillances incontrôlables. Lorsque les taux d'erreur dépassent les seuils configurés, le système suspend l'extraction, envoie des rapports d'erreur détaillés et attend une intervention manuelle. Cela évite l'accumulation de milliers d'enregistrements invalides qui nécessiteraient un nettoyage ultérieur.

La catégorisation des erreurs permet de hiérarchiser les corrections. Nous classons les échecs de validation en catégories telles que les erreurs de sélection, les incompatibilités de format, les problèmes d'exhaustivité et les incohérences logiques. La compréhension de la répartition des erreurs guide les efforts de dépannage et aide à identifier rapidement les causes profondes.

L'intégration avec des outils de surveillance tels que Prometheus, Grafana ou Datadog offre une observabilité de niveau entreprise. Nous exportons les métriques de validation vers ces plateformes à des fins de suivi historique, d'analyse des tendances et de corrélation avec les métriques d'infrastructure. Cela garantit une qualité élevée des données pour toutes les opérations de scraping.

En mettant en œuvre ces pratiques de validation en temps réel, nous détectons les problèmes de qualité à la source. Cette approche proactive de la vérification change fondamentalement la façon dont nous gérons les projets de scraping, en réduisant le temps de débogage et en garantissant une qualité des données constante du premier enregistrement au dernier.

Étape 4 : Comment vérifier les données web scrapées à l'aide d'outils de vérification spécialisés

La quatrième étape de notre processus de vérification des données consiste à exploiter des plateformes de vérification dédiées. Ces plateformes vont au-delà des simples vérifications de format pour valider l'utilisabilité réelle de vos données de contact récupérées. Alors que la validation du format confirme que les données semblent correctes, des outils de vérification spécialisés testent réellement si les adresses email peuvent recevoir des messages, si les numéros de téléphone sont connectés à des lignes actives et si les adresses physiques correspondent à des lieux de livraison. Cette distinction fait toute la différence entre des données qui semblent correctes et des données qui fonctionnent réellement dans des environnements de production.

Les services de vérification spécialisés résolvent un problème critique que nous rencontrons fréquemment dans les projets de scraping web. Vous pouvez collecter des milliers d'adresses email, de numéros de téléphone et d'adresses postales parfaitement formatés, mais sans vérification, un pourcentage important sera invalide, déconnecté ou non livrable. Cela crée de sérieux problèmes en aval : les e-mails rejetés nuisent à la réputation de l'expéditeur, les numéros de téléphone déconnectés font perdre du temps à l'équipe commerciale et les adresses invalides entraînent des retours de courrier et un gaspillage des dépenses marketing.

Nous intégrons des outils de vérification à ce stade, car ils nécessitent des formats de données déjà validés pour fonctionner efficacement. Ces services attendent des entrées standardisées et renvoient des résultats de vérification détaillés qui nous indiquent les prochaines étapes à suivre dans le pipeline de qualité des données.

Vérification des emails à grande échelle : outils et techniques

La vérification des emails représente l'une des étapes de vérification les plus critiques pour les données de contact récupérées. La validation du format seule ne nous dit rien sur l'existence réelle d'une adresse ou sur sa capacité à recevoir des messages. Une adresse email peut avoir une syntaxe parfaite, mais appartenir à un compte supprimé, à un piège à spam ou à un domaine qui n'accepte plus de courrier. L'utilisation d'adresses email non vérifiées dans les campagnes de marketing entraîne des taux de rebond qui peuvent rapidement nuire à votre réputation d'expéditeur et à votre délivrabilité.

Nous mettons en œuvre la vérification des emails à grande échelle en utilisant des services qui effectuent plusieurs contrôles de validation au-delà de la simple analyse du format. Le processus de vérification examine plusieurs facteurs critiques qui déterminent si une adresse email est légitime et active.

Les services professionnels de vérification des emails vérifient la syntaxe pour confirmer la conformité RFC, valident l'existence du domaine par des recherches DNS, vérifient les enregistrements MX pour s'assurer que le domaine peut recevoir des emails et effectuent des handshakes SMTP pour confirmer l'existence de la boîte mail spécifique sans envoyer de message. La vérification avancée identifie également les adresses emails jetables provenant de services de messaging temporaires, détecte les adresses basées sur des rôles telles que info@ ou support@ qui ont souvent un engagement moindre, et signale les pièges à spam connus qui peuvent gravement nuire à la réputation de l'expéditeur.

Services de vérification d'adresses email en ligne

Les services de vérification des email en ligne ont considérablement évolué, offrant des capacités de validation sophistiquées grâce à de simples intégrations API. Ces plateformes traitent les demandes de vérification en temps réel ou par lots, en fonction de vos exigences en matière de flux de travail et de vos besoins en termes de volume.

Lorsque nous évaluons les services de vérification, nous nous concentrons sur plusieurs fonctionnalités clés. Les taux de précision de la vérification doivent dépasser 95 % pour les déterminations valides/non valides. La vitesse de traitement est importante pour les intégrations en temps réel, la plupart des services de qualité renvoyant des résultats en moins de deux secondes par adresse. Le service doit fournir des codes de résultat détaillés, permettant de prendre des décisions nuancées sur la qualité des données.

Les meilleurs outils de vérification des email incluent également la détection « catch-all », qui identifie les domaines configurés pour accepter les email pour n'importe quelle adresse, rendant impossible la vérification individuelle des boîtes mail. Ils détectent les problèmes de syntaxe qui pourraient passer la validation regex de base, identifient les fournisseurs d'email temporaires et signalent les adresses présentant des antécédents de rebonds.

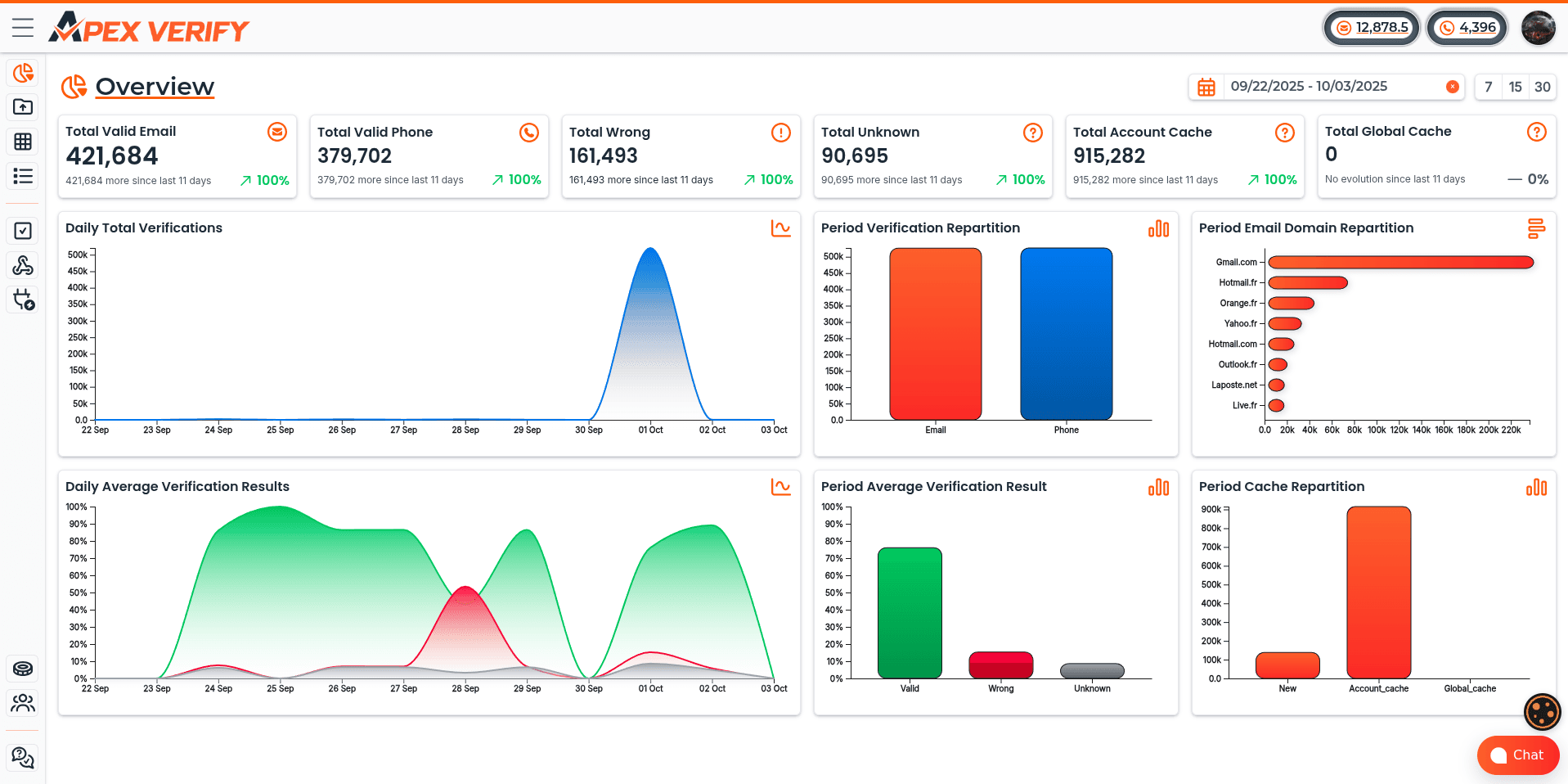

Mise en œuvre d'ApexVerify pour la vérification des emails

Nous mettons fréquemment en œuvre ApexVerify comme solution de vérification des email, car il offre des capacités de vérification complètes grâce à une intégration API simple. La plateforme gère à la fois la vérification en temps réel pendant le scraping et le traitement par lots pour les grands ensembles de données, ce qui nous donne la flexibilité de choisir l'approche qui correspond le mieux aux exigences de chaque projet.

ApexVerify effectue des vérifications à plusieurs niveaux, notamment la validation syntaxique, la vérification du domaine, la validation SMTP et l'évaluation de la délivrabilité. Le service renvoie des résultats détaillés avec des scores de confiance, ce qui nous permet de prendre des décisions éclairées dans les cas limites.

Pour l'intégration en temps réel, nous implémentons des appels API immédiatement après le scraping de chaque adresse email. Cette approche fournit un retour instantané sur la qualité des données et nous permet de signaler les sources problématiques avant de collecter de grands volumes de données erronées. Pour le traitement par lots, nous collectons les emails scrapés dans des ensembles de données et les soumettons à une vérification groupée, ce qui offre des avantages en termes de coûts et des délais de traitement globaux plus courts pour les projets de grande envergure.

Les résultats de la vérification comprennent des codes d'état tels que valide, invalide, catch-all, jetable, basé sur le rôle et inconnu. Chaque résultat comprend un score de confiance de 0 à 100, ce qui nous aide à établir des seuils de qualité. Nous conservons généralement les email dont le score de confiance est supérieur à 90, signalons les scores compris entre 70 et 90 pour un examen manuel et rejetons les scores inférieurs à 70 comme non fiables.

Vérification des numéros de téléphone à grande échelle

La vérification des numéros de téléphone présente des défis particuliers, car les numéros de téléphone récupérés se présentent sous d'innombrables formats, peuvent inclure des extensions ou du texte supplémentaire, et peuvent représenter des services mobiles, fixes ou VoIP avec des caractéristiques et une valeur différentes à des fins commerciales. Le simple fait de confirmer qu'un numéro comporte le bon nombre de chiffres ne nous dit rien sur le fait que ce numéro est réellement connecté à une ligne active.

Lorsque nous mettons en œuvre la vérification des numéros de téléphone à grande échelle, nous nous concentrons sur trois objectifs principaux : confirmer que le numéro est actif et peut recevoir des appels ou des SMS, identifier le type de ligne afin de comprendre comment utiliser au mieux le numéro, et normaliser les formats pour assurer la cohérence de notre ensemble de données. Ces étapes de vérification transforment les numéros de téléphone récupérés à partir de données incertaines en points de contact fiables.

Méthodes de vérification des numéros de téléphone en ligne

Les services de vérification des numéros de téléphone en ligne utilisent une combinaison de recherches dans des bases de données, de requêtes auprès des opérateurs et de tests de connectivité en direct pour valider les numéros de téléphone sans les appeler. Cette vérification s'effectue à l'aide de bases de données de télécommunications qui suivent l'attribution, la portabilité et le statut des numéros.

Le processus de vérification commence par la normalisation des formats, en convertissant les différents formats d'entrée au format international E.164. Cette normalisation garantit un formatage cohérent et permet des recherches précises dans la base de données. Le service effectue ensuite une recherche auprès de l'opérateur pour identifier le fournisseur de télécommunications et le type de ligne, détermine si le numéro est un numéro de mobile, de fixe ou de VoIP, et vérifie le statut d'activation pour confirmer que le numéro est actuellement en service.

Un outil de vérification de numéro de téléphone de qualité fournit également une validation géographique, confirmant que l'indicatif régional et l'emplacement correspondent aux régions attendues. Il identifie les lignes prépayées par rapport aux lignes postpayées, ce qui peut indiquer la qualité des données et les données démographiques des utilisateurs. Certains services proposent une évaluation des risques basée sur les antécédents de fraude ou les plaintes pour spam associées au numéro.

ApexVerify gère la vérification des numéros de téléphone via la même plateforme unifiée que celle utilisée pour la vérification des adresses email. Cette intégration simplifie les flux de travail en fournissant une interface API cohérente pour plusieurs types de données. Le service valide les numéros de téléphone dans tous les formats internationaux, identifie l'opérateur et le type de ligne, confirme l'état d'activation actuel et signale les numéros à haut risque ou frauduleux sur la base d'une analyse des modèles.

Vérification et normalisation des adresses

La vérification des adresses physiques représente sans doute le défi le plus complexe en matière de vérification, car les adresses comportent plusieurs éléments, suivent des conventions de formatage différentes selon les régions et peuvent être abrégées ou incomplètes dans les données sources. Une adresse peut sembler plausible, mais représenter un lieu qui n'existe pas, contenir un numéro d'unité invalide ou ne pas pouvoir recevoir de courrier.

Nous mettons en œuvre la vérification des adresses afin de confirmer que les adresses récupérées correspondent à des lieux réels et accessibles. Cette vérification implique l'analyse des composants de l'adresse, la normalisation des formats selon les conventions des services postaux, la confirmation de l'existence du lieu grâce au géocodage et l'évaluation de la délivrabilité à des fins d'envoi postal.

Solutions de vérification d'adresses en ligne

Les services de vérification d'adresses en ligne se connectent aux bases de données postales et aux systèmes de géocodage afin de valider les adresses par rapport à des sources faisant autorité. Ces plateformes analysent les formats d'adresses incohérents, corrigent les erreurs courantes et renvoient des adresses normalisées avec validation du point de livraison.

Le processus de vérification commence par l'analyse de l'adresse, qui la décompose en éléments normalisés : numéro de rue, nom de rue, désignation de l'unité, ville, état et code postal. Cette analyse traite divers formats d'entrée et identifie les éléments même lorsque les adresses sont mal formatées ou contiennent des informations superflues.

Un outil de vérification d'adresse complet effectue une normalisation afin de convertir les adresses dans des formats correspondant aux bases de données des services postaux. Pour les adresses aux États-Unis, cela signifie une normalisation USPS avec des abréviations et un formatage approuvés. Le service valide chaque composant par rapport aux registres officiels, confirme que le code postal correspond à la ville et à l'État, et vérifie que la combinaison rue et numéro existe.

Le géocodage fournit une validation supplémentaire en convertissant les adresses en coordonnées géographiques. Cela permet de confirmer que le lieu existe physiquement et de calculer les distances pour la planification logistique. L'évaluation de la délivrabilité vérifie si l'adresse peut recevoir du courrier, signale les emplacements tels que les boîtes postales lorsque des adresses physiques sont requises, identifie les propriétés vacantes et détecte les adresses signalées comme non livrables par les services postaux.

Lors de la mise en œuvre de la vérification d'adresse à grande échelle, le traitement par lots offre des avantages significatifs en termes d'efficacité. Nous pouvons vérifier des milliers d'adresses en quelques minutes grâce à des soumissions API en masse. Les résultats de la vérification indiquent si les adresses sont valides, invalides ou incertaines, et fournissent des versions corrigées et normalisées des adresses valides.

Vérification des données tout-en-un avec ApexVerify.com

La gestion de plusieurs services de vérification crée une complexité inutile dans les flux de données. Chaque plateforme dispose de sa propre API, de son propre système de facturation, de son propre tableau de bord et de ses propres formats de données. Nous avons constaté que la consolidation de la vérification via une plateforme unique simplifie considérablement l'intégration et réduit les frais généraux opérationnels.

Les plateformes de vérification de données tout-en-un telles que apexverify.com fournissent des solutions unifiées qui gèrent la vérification des email, des numéros de téléphone et des adresses via des interfaces cohérentes. Cette consolidation offre de multiples avantages qui vont au-delà de la simple commodité.

Une plateforme unifiée offre une conception API cohérente pour tous les types de vérification. Au lieu d'apprendre et d'intégrer trois API distinctes, nous mettons en œuvre un modèle d'intégration unique qui gère plusieurs types de données. Cela réduit le temps de développement et simplifie la maintenance à mesure que nos projets de scraping évoluent.

Les remises sur volume deviennent plus accessibles lorsque toutes les vérifications sont effectuées par un seul fournisseur. Au lieu de répartir le volume de vérification entre plusieurs services, nous concentrons notre utilisation afin d'atteindre plus rapidement des niveaux de remise plus élevés. Cela peut réduire les coûts de vérification de 30 à 50 % par rapport à l'utilisation de fournisseurs distincts pour chaque type de données.

Le tableau de bord unifié permet une surveillance centralisée des mesures de vérification pour tous les types de données. Nous pouvons suivre les volumes de vérification, les tendances en matière de précision et la répartition des coûts à partir d'une seule interface. Cette visibilité permet un meilleur contrôle de la qualité et une meilleure gestion du budget par rapport à la gestion de plusieurs tableaux de bord de services.

Lorsque nous mettons en œuvre ApexVerify pour une vérification complète des données, nous bénéficions d'avantages supplémentaires grâce à des workflows de vérification intégrés. La plateforme permet une vérification séquentielle où les résultats de la vérification des emails peuvent déclencher une vérification téléphonique pour les contacts à forte valeur ajoutée. Nous pouvons établir une notation de qualité unifiée qui combine les résultats de vérification pour tous les types de données. Le service maintient des pratiques cohérentes en matière de traitement des données et de confidentialité pour tous les types de vérification, ce qui simplifie la gestion de la conformité.

L'analyse des coûts montre systématiquement que la vérification consolidée réduit à la fois les coûts directs de vérification grâce à des remises sur volume et les coûts indirects grâce à une intégration et une gestion simplifiées. Pour les projets nécessitant la vérification de plusieurs types de données de contact, une plateforme unifiée telle que apexverify.com offre une efficacité et une rentabilité supérieures par rapport à la gestion de services de vérification distincts.

Comprendre comment vérifier les données web récupérées à l'aide d'outils spécialisés transforme la fiabilité de vos ensembles de données. Ces services de vérification valident que vos données sont non seulement correctement formatées, mais aussi réellement fonctionnelles dans des applications concrètes, protégeant ainsi vos projets des conséquences coûteuses liées à l'utilisation d'informations de contact non vérifiées.

Étape 5 : Contourner les systèmes anti-bots et les défis techniques

Les systèmes anti-bot constituent un obstacle important à la collecte de données web vérifiées à grande échelle. Ces systèmes détectent les scrapers automatisés, soit en bloquant l'accès, soit en proposant un contenu modifié. Les technologies anti-bot modernes utilisent l'analyse comportementale et l'empreinte digitale des appareils pour distinguer les humains des bots.

Nous recommandons de commencer par des techniques de scraping simples et respectueuses. L'ajout de modèles de comportement similaires à ceux des humains, tels que des délais aléatoires et des agents utilisateurs rotatifs, permet d'éviter la détection. Pour les sites plus difficiles, des navigateurs sans interface utilisateur avec des configurations furtives sont nécessaires.

Le principe qui guide notre approche est la collecte respectueuse des données. Notre objectif est de recueillir des données sans surcharger les serveurs ni contourner les mesures de sécurité. Cela garantit des pratiques de scraping durables qui préservent la qualité des données et respectent les ressources des sites web.

Contourner Captcha et Google reCAPTCHA

Les défis Captcha apparaissent lorsque les sites web détectent des comportements suspects. Comprendre pourquoi les systèmes Captcha se déclenchent nous aide à les contourner plus efficacement. La plupart des implémentations Captcha s'activent en fonction de la fréquence des requêtes et des anomalies comportementales.

Nous nous concentrons d'abord sur les stratégies de prévention. Un rythme de requêtes approprié, avec des délais aléatoires de 2 à 5 secondes, imite les habitudes de navigation humaines. Des empreintes de navigateur complètes signalent une activité légitime du navigateur.

Lorsque Google reCAPTCHA apparaît, plusieurs options s'offrent à nous. La rotation des proxys résidentiels permet de réinitialiser les scores de réputation associés aux adresses IP. Le maintien des sessions de navigation avec des cookies et un stockage local démontre la continuité.

Pour les projets où la résolution de captcha devient inévitable, des services tiers fournissent un accès API à des solveurs humains ou à des solutions d'apprentissage automatique. Nous soulignons que le recours à ces services indique que notre approche de scraping doit être affinée.

Le contournement des mesures de sécurité soulève des considérations éthiques et juridiques. De nombreuses conditions d'utilisation interdisent explicitement l'accès automatisé. Nous recommandons toujours d'examiner les exigences légales et de déterminer si les API ou les partenariats de données offrent des alternatives légitimes.

Gérer les systèmes de détection des bots

Les plateformes anti-bots d'entreprise sont de plus en plus sophistiquées. Elles utilisent l'apprentissage automatique et l'analyse comportementale pour identifier le trafic automatisé. Comprendre le fonctionnement des principales plateformes nous aide à configurer des scrapers qui génèrent des données plus propres et plus fiables.

Les trois principaux systèmes de détection de bots d'entreprise, Cloudflare, Akamai et Imperva, utilisent chacun des méthodologies de détection distinctes. Nous avons besoin d'approches adaptées à chaque plateforme afin de maintenir la cohérence de la collecte de données et la précision de la vérification.

Comprendre les défis de Cloudflare

La gestion des bots de Cloudflare fonctionne à travers plusieurs couches de vérification. Les défis JavaScript vérifient la capacité d'exécution du navigateur. Les contrôles d'intégrité du navigateur détectent les outils d'automatisation en examinant les API du navigateur et les incohérences dans leur mise en œuvre.

La limitation du débit bloque les requêtes excessives provenant d'une seule source, tandis que les pages de défi doivent être résolues avant d'accéder au contenu. Nous avons constaté qu'une configuration appropriée des en-têtes constitue la base pour travailler avec les sites protégés par Cloudflare. Un rythme de requêtes bien inférieur aux limites de débit empêche le déclenchement de défis plus agressifs.

L'utilisation de navigateurs sans interface graphique configurés pour passer les défis JavaScript s'avère essentielle. Des outils tels que Playwright et Selenium avec des plugins furtifs peuvent exécuter le JavaScript de Cloudflare sans être détectés lorsqu'ils sont correctement configurés. La clé réside dans la désactivation des indicateurs d'automatisation que Cloudflare analyse.

Contourner la protection Akamai

La détection sophistiquée des bots d'Akamai utilise une analyse comportementale qui identifie les modèles d'interaction non humains. Leur système examine la cohérence temporelle, les mouvements de la souris, le comportement de défilement et la dynamique des frappes clavier. L'empreinte digitale des appareils reconnaît et bloque les outils d'automatisation connus en comparant les caractéristiques du navigateur à des bases de données de signatures de bots.

Les défis adaptatifs augmentent la difficulté pour les bots suspects, créant ainsi une barrière progressive. Nous réduisons la probabilité de détection grâce à plusieurs approches. La rotation des proxys résidentiels répartit les requêtes entre différentes adresses IP ayant une réputation irréprochable.

La randomisation des délais d'interaction empêche les modèles cohérents signalés par l'analyse comportementale d'Akamai. La persistance de session conserve les cookies et le stockage entre les requêtes, démontrant ainsi une continuité que les algorithmes reCAPTCHA reconnaissent.

Imperva et détection avancée

Imperva représente une protection de niveau entreprise qui inclut la détection basée sur l'apprentissage automatique, le blocage au niveau du réseau et la protection DDoS intégrée. Leur système analyse simultanément les modèles de trafic à plusieurs niveaux. Cela fait d'Imperva l'une des plateformes les plus difficiles à utiliser.

Lorsque le scraping de sites protégés par Imperva nécessite des services proxy professionnels et une rotation des adresses IP résidentielles, nous savons que nous avons affaire à une protection sérieuse. L'empreinte digitale au niveau du réseau permet d'identifier les adresses IP des centres de données et de bloquer des plages entières. Seules les adresses IP résidentielles ayant une réputation irréprochable réussissent généralement.

L'automatisation du navigateur doit être presque parfaite, avec des empreintes digitales complètes qui correspondent exactement aux appareils réels. Toute incohérence entre l'identité déclarée du navigateur et ses capacités réelles déclenche une détection. Pour les données de grande valeur protégées par Imperva, nous recommandons souvent d'explorer les possibilités d'accès légitime aux API ou les partenariats de données.

Gestion des en-têtes HTTP et des chaînes User-Agent

Des en-têtes HTTP spécifiques doivent être configurés pour apparaître comme du trafic de navigateur légitime. Les en-têtes manquants ou mal configurés signalent immédiatement les requêtes comme automatisées. Nous configurons des ensembles d'en-têtes complets qui correspondent précisément aux navigateurs réels, car même des écarts mineurs peuvent déclencher des algorithmes de détection des bots.

La chaîne d'agent utilisateur identifie le navigateur et le système d'exploitation. Nous utilisons des combinaisons courantes et populaires telles que Chrome sur Windows ou Safari sur macOS. L'en-tête Accept spécifie les types de contenu attendus, qui comprennent généralement text/html, application/xhtml+xml et d'autres formats demandés par les navigateurs.

Les en-têtes supplémentaires essentiels comprennent :

- Accept-Language : indique les préférences linguistiques (par exemple, « en-US,en;q=0.9 »)

- Accept-Encoding : spécifie la prise en charge de la compression (par exemple, « gzip, deflate, br »)

- Connection : contrôle la persistance de la connexion (généralement « keep-alive »)

- Referer : affiche la page précédente lorsque cela est approprié pour le flux de navigation

- DNT : préférence « Do Not Track » (de plus en plus courante)

Voici un exemple d'en-têtes http complets pour Chrome sous Windows :

- User-Agent : Mozilla/5.0 (Windows NT 10.0 ; Win64 ; x64) AppleWebKit/537.36 (KHTML, comme Gecko) Chrome/121.0.0.0 Safari/537.36

- Accept : text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8

- Accepter la langue : en-US,en;q=0.9

- Accept-Encoding : gzip, deflate, br

- Connexion : keep-alive

Pour que la rotation des en-têtes soit convaincante, il faut maintenir la cohérence au sein de chaque session. Nous ne modifions pas l'agent utilisateur en cours de session, car les navigateurs ne le font jamais. Au lieu de cela, nous faisons varier les en-têtes entre les sessions tout en conservant la cohérence interne de chaque session. Cette approche imite la façon dont différents utilisateurs avec différents navigateurs accèdent au même site.

Empreinte digitale du navigateur et détection de l'automatisation

Les sites identifient les navigateurs automatisés grâce à une analyse des empreintes qui examine simultanément des dizaines de caractéristiques du navigateur. L'empreinte digitale Canvas lit la façon dont les navigateurs affichent les graphiques, créant des signatures uniques basées sur les différences entre les moteurs de rendu. L'empreinte digitale WebGL analyse les capacités graphiques 3D, tandis que l'empreinte digitale du contexte audio examine les caractéristiques de traitement audio.

L'énumération des polices révèle les polices installées, la détection des plugins identifie les extensions du navigateur et la détection WebDriver identifie Selenium et les outils d'automatisation similaires. La propriété navigator.webdriver renvoie la valeur « true » dans les navigateurs automatisés, les signalant immédiatement comme des robots.

Nous utilisons plusieurs techniques de configuration pour réduire la détectabilité des empreintes digitales. La désactivation des indicateurs WebDriver supprime l'indicateur d'automatisation le plus évident. Dans Selenium, nous utilisons des options telles que --disable-blink-features=AutomationControlled pour masquer les signaux d'automatisation.

La randomisation de la sortie du canevas empêche la cohérence des empreintes digitales d'une session à l'autre. Les bibliothèques furtives pour Puppeteer et Playwright gèrent automatiquement de nombreuses incohérences d'empreintes digitales. Ces outils modifient le comportement du navigateur afin de se rapprocher davantage des modèles humains.

Les navigateurs anti-détection offrent une résistance préconfigurée aux empreintes digitales, créant des profils crédibles qui passent à travers les systèmes de détection sophistiqués. La clé d'une navigation réussie dans la détection des robots réside dans une escalade progressive. Nous commençons par des configurations de base et n'ajoutons de la complexité que lorsque les approches plus simples échouent. Cette stratégie minimise l'investissement en ressources tout en maximisant la qualité des données et la précision de la vérification tout au long de nos projets de scraping.

Étape 6 : Nettoyez et normalisez votre ensemble de données scrapées

Une fois que vous avez collecté les données web, le vrai travail commence avec la transformation des informations brutes incohérentes en un format standardisé. Les données brutes scrapées contiennent des irrégularités de formatage, des problèmes d'encodage et des problèmes structurels qui les rendent impropres à une utilisation immédiate. Nous devons appliquer des processus systématiques de nettoyage et de normalisation pour garantir que nos efforts de vérification des données scrapées donnent des résultats fiables.

Cette phase de transformation comble le fossé entre l'extraction et l'analyse. Sans un nettoyage approprié, même des données parfaitement extraites peuvent compromettre vos projets. L'objectif est de convertir des données web désordonnées en données scrapées cohérentes et vérifiées qui répondent à vos normes de qualité et permettent de prendre des décisions commerciales précises.

Notre approche systématique du nettoyage des données

Le nettoyage des données pour le scraping web nécessite un processus méthodique qui traite les artefacts d'extraction courants. Nous commençons par supprimer les balises HTML et les entités qui ont survécu à la phase d'extraction initiale. Ces résidus peuvent corrompre votre ensemble de données s'ils ne sont pas traités.

Notre pipeline de nettoyage traite plusieurs tâches critiques de manière systématique. Tout d'abord, nous supprimons les caractères indésirables tels que les symboles spéciaux et les caractères de contrôle que les navigateurs affichent mais que les bases de données rejettent. Ensuite, nous supprimons les espaces blancs superflus tout en conservant les espacements significatifs dans les descriptions de produits et les adresses.

La normalisation du codage des textes constitue une autre étape clé. Nous convertissons tout le contenu récupéré au format UTF-8 afin de traiter les caractères internationaux de manière cohérente. Cela permet d'éviter les problèmes d'affichage et garantit la compatibilité entre les différents systèmes et plateformes.

Nous corrigeons également les erreurs d'extraction évidentes au cours de cette phase. Les champs fusionnés où deux points de données se sont mélangés sont séparés. Les valeurs tronquées qui ont été coupées lors de l'extraction déclenchent de nouvelles tentatives de scraping ou sont signalées pour être vérifiées manuellement.

La documentation joue un rôle essentiel dans notre processus de nettoyage. Nous enregistrons chaque règle de transformation appliquée à l'ensemble de données. Cette documentation permet aux membres de l'équipe de comprendre exactement comment les données brutes ont été vérifiées et extraites, et garantit une application cohérente à tous les enregistrements.

Techniques de normalisation et de standardisation

Différents sites web formatent les mêmes informations de multiples façons. Un prix peut apparaître sous la forme « 19,99 $ », « 19,99 USD » ou « 19,99 € ». Nos techniques de normalisation créent une uniformité à partir de ce chaos, rendant la vérification des données extraites plus fiable.

Nous appliquons des transformations spécifiques à chaque type de données que nous rencontrons. Les valeurs de prix sont converties en une devise standard et un format numérique sans symboles. Les valeurs de date sont transformées au format ISO 8601 (AAAA-MM-JJ), éliminant ainsi toute ambiguïté entre les différents formats régionaux.

Les numéros de téléphone posent des défis particuliers dans les ensembles de données internationaux. Nous les normalisons au format international E.164, qui offre une structure cohérente quel que soit le formatage de la source. Cette normalisation améliore considérablement les taux de correspondance lors du recoupement des enregistrements.

La normalisation des adresses consiste à convertir le texte en majuscules et à appliquer les abréviations postales standard. « 123 main street » devient « 123 Main St » conformément aux directives de l'USPS. Cette cohérence améliore la qualité des données web et permet une meilleure déduplication.

Les valeurs catégorielles nécessitent une attention particulière lors de la normalisation. Des variations telles que « en stock », « disponible » et « in-stock » représentent toutes le même statut. Nous mappons ces variations à des valeurs standard uniques, créant ainsi des données catégorielles propres pour l'analyse.

Nous conservons les valeurs brutes d'origine parallèlement aux versions normalisées dans la mesure du possible. Cette pratique permet de préserver la traçabilité des données et de les retraiter si les règles de normalisation doivent être ajustées. Vous pouvez toujours vous référer aux données sources en cas de question.

Stratégies de déduplication efficaces